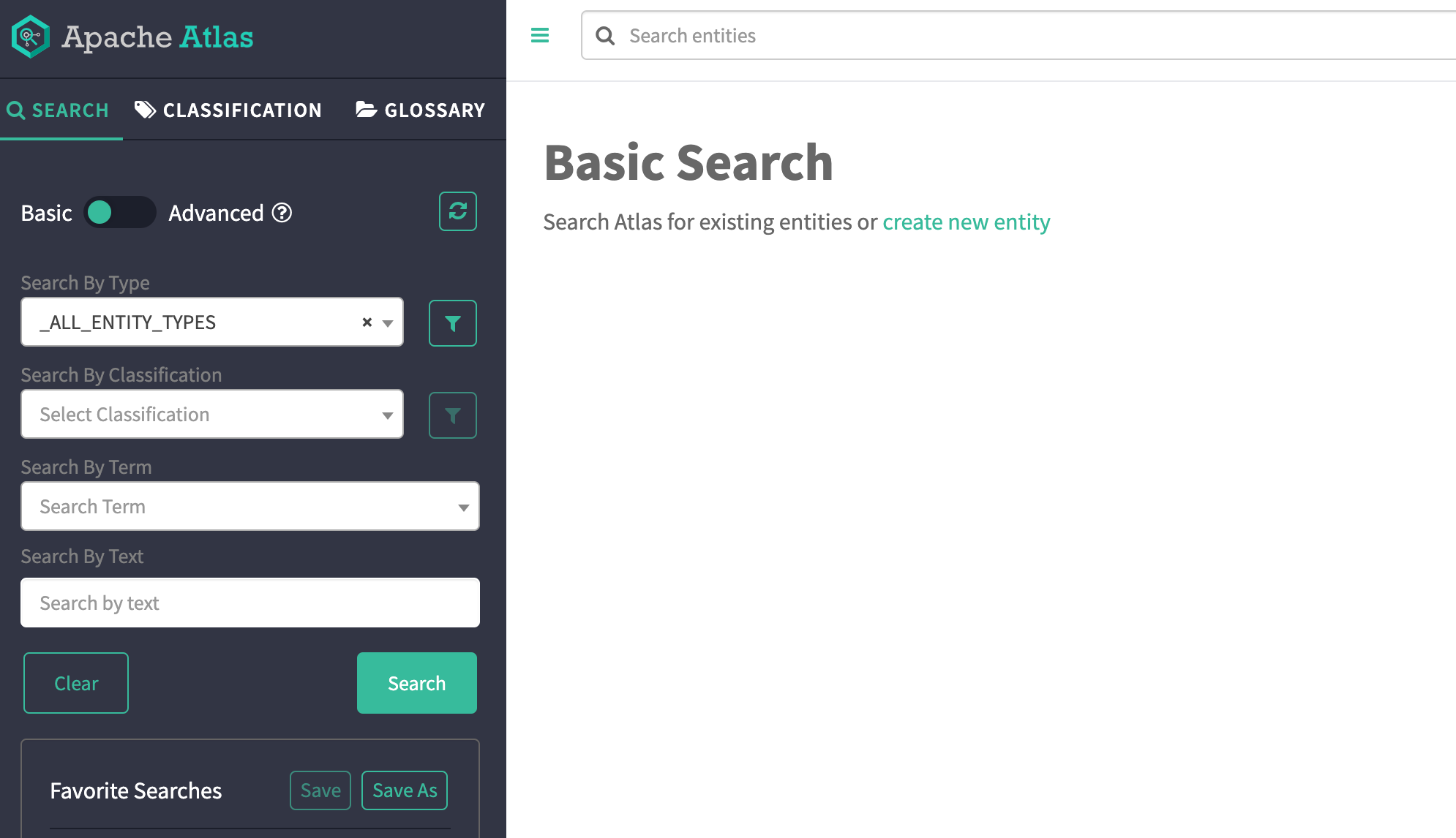

아파치 아틀라스는 데이터 카탈로그 플랫폼으로 사내의 데이터를 모아서 보여주는 역할을 합니다.

데이터가 작을 때는 사용자가 데이터의 위치를 기억하고 사용하는 것이 가능하지만,

데이터가 커지고 데이터를 수집하는 주체가 늘어나면 모든 데이터르 기억하고 이용하는 것이 불가능해지며, 여기 저기 데이터가 난립하게 됩니다.

이럴 때 필요한 것이 데이터 카탈로그(Data Catalog)입니다. 사내 hive, hbase, hdfs, sqoop 등에 저장된 데이터를 한 곳에 모아서 데이터의 계보, 칼럼의 정보등을 보여줍니다.이를 제공하는 것이 아틀라스입니다.

아틀라스 빌드

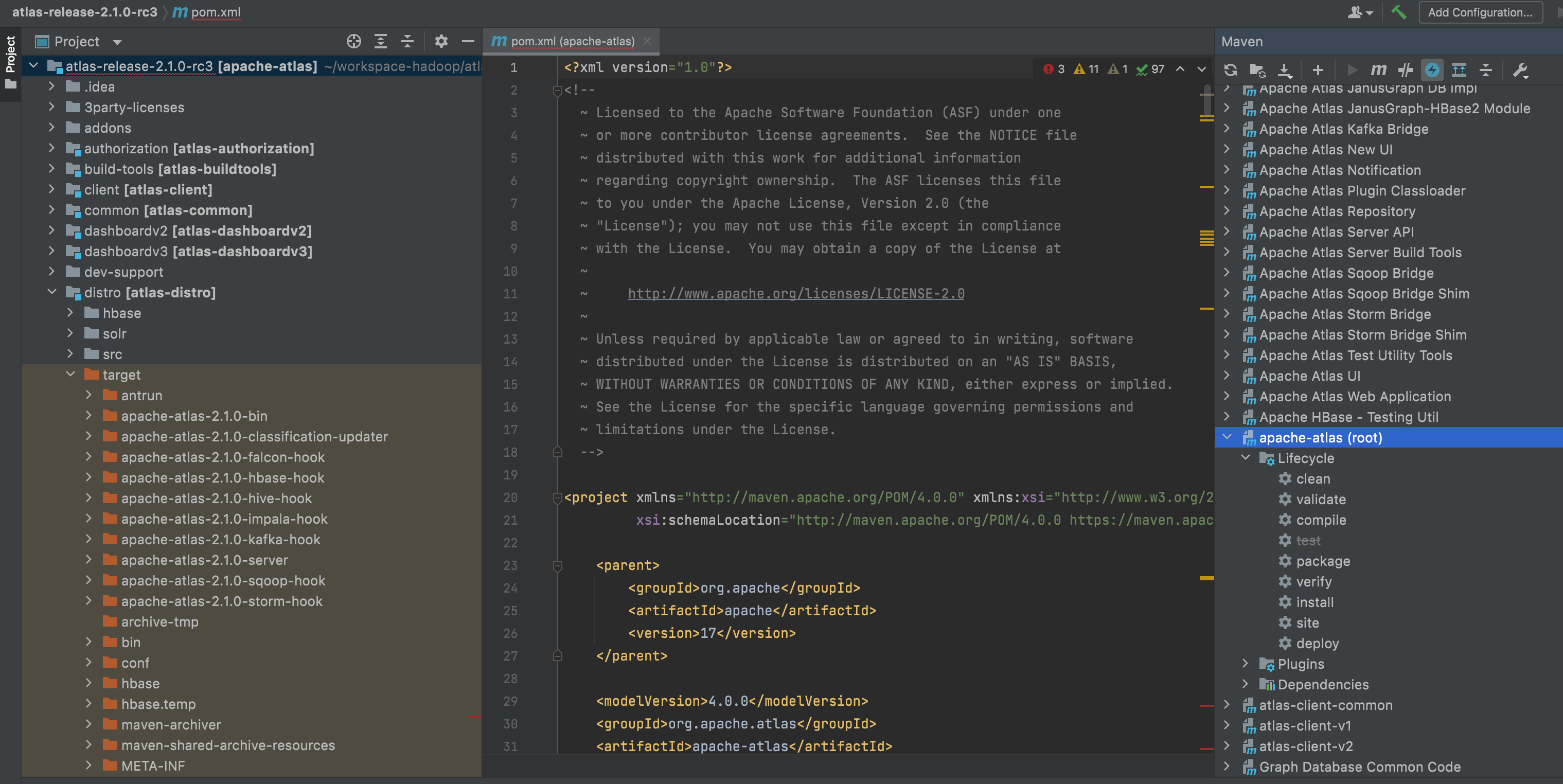

아틀라스는 인텔리j를 이용하여 편리하게 빌드할 수 있습니다.

- 아틀라스 소스 코드를 다운로드

- git 등에서 소스코드를 다운로드 합니다.

- 저는 atlas-release-2.1.0-rc3 를 다운로드 했습니다.

- 다운로드한 파일의 압축을 풀고 인텔리j로 임포트 합니다.

- File > New > Project from Existing Source

- 를 이용하여 소스코드를 불러옵니다.

- 메이븐 탭에서 Skip Tests를 클릭한 후, apache-atlas(root)에서 package를 더블 클릭해서 빌드를 진행합니다.

- 메이븐 jar 파일의 다운로드, 인덱싱 상태에 따라 빌드가 실패할 수 있는데 이 작업들이 끝날 때까지 조금 기다렸다가 다시 진행하면 됩니다.

- 작업이 끝나면 distro 폴더에서 빌드 파일을 확인할 수 있습니다.

아틀라스 실행

- 빌드 후 apache-atlas-2.1.0-server.tar.gz 파일의 압축을 해제

- 압축을 풀면 다음과 같은 파일 목록을 확인할 수 있습니다.

$ ll

total 68

drwxr-xr-x 10 deploy deploy 4096 Aug 20 02:19 ./

drwxr-xr-x 4 root root 4096 Aug 20 02:03 ../

-rwxrwxr-x 1 deploy deploy 210 Jul 8 2020 DISCLAIMER.txt*

-rwxrwxr-x 1 deploy deploy 14289 Jul 8 2020 LICENSE*

-rwxrwxr-x 1 deploy deploy 169 Jul 8 2020 NOTICE*

-rw-r--r-- 1 deploy deploy 4 Aug 20 02:19 atlas.pid

drwxr-xr-x 2 deploy deploy 4096 Aug 20 02:04 bin/

drwxr-xr-x 5 deploy deploy 4096 Aug 20 02:03 conf/

drwxr-xr-x 5 deploy deploy 4096 Aug 20 02:16 data/

drwxr-xr-x 8 deploy deploy 4096 Aug 20 02:04 hbase/

drwxr-xr-x 7 deploy deploy 4096 Jul 8 2020 models/

drwxr-xr-x 3 deploy deploy 4096 Aug 20 02:03 server/

drwxr-xr-x 9 deploy deploy 4096 Aug 9 11:40 solr/

drwxr-xr-x 4 deploy deploy 4096 Aug 20 02:03 tools/- conf/ 아래 atlas-env.sh 파일에서 설정을 수정할 수 있습니다.

- 아틀라스는 솔라(solr), HBase를 메타정보와 인덱스정보를 보관하는 용도로 사용하기 때문에 따로 클러스터를 구축한다면 이 두 개의 컴포넌트 정보를 추가해야 합니다.

- 여기서는 아틀라스에 내장된 솔라, HBase를 이용해서 실행하기 때문에 atlas-env.sh에 다음과 같이 설정후 실행합니다.

# indicates whether or not a local instance of HBase should be started for Atlas

export MANAGE_LOCAL_HBASE=true

# indicates whether or not a local instance of Solr should be started for Atlas

export MANAGE_LOCAL_SOLR=true

# indicates whether or not cassandra is the embedded backend for Atlas

export MANAGE_EMBEDDED_CASSANDRA=false

# indicates whether or not a local instance of Elasticsearch should be started for Atlas

export MANAGE_LOCAL_ELASTICSEARCH=false- 이제 아틀라스를 실행합니다.

- 아틀라스를 처음실행하면 기본 데이터 모델을 생성하는데 시간이 많이 소요됩니다.

- 10~20 분정도 소요 될 수 있기 때문에 인내심을 갖고 기다려야 합니다.

- 아틀라스가 실행되면 관리자 계정을 등록후 이용하면 됩니다.

- 관리자 계정은 rest api를 이용합니다.

curl -u [username]:[password] http://localhost:21000/api/atlas/admin/version

https://atlas.apache.org/2.0.0/InstallationSteps.html

Apache Atlas – Building & Installing Apache Atlas

Building & Installing Apache Atlas Building Apache Atlas Download Apache Atlas 1.0.0 release sources, apache-atlas-1.0.0-sources.tar.gz, from downloads page. Then follow the instructions below to to build Apache Atlas. tar xvfz apache-atlas-1.0.0-sources.t

atlas.apache.org

반응형

'빅데이터' 카테고리의 다른 글

| [presto] 프레스토(presto) 설치 및 실행 (0) | 2021.08.23 |

|---|---|

| [amundsen] 도커를 이용한 아문센(amundsen) 실행 방법 (0) | 2021.08.22 |

| [ranger] 아파치 레인저 빌드 및 실행 하기 (0) | 2021.08.19 |

| [avro] python avro api 에서 The datum XX is not an example of the schema 오류 (0) | 2021.07.13 |

| [avro] 파이썬을 이용한 avro 예제 (0) | 2021.07.07 |