하둡 2.10.0 버전에서 데이터 노드를 재시작할 때 다음과 같은 오류가 발생하였습니다. 여러 대의 노드에서 동일한 작업을 진행하였는데 하나의 노드에서만 이런 문제가 발생하였습니다.

2022-07-05 15:15:19,119 INFO org.apache.hadoop.hdfs.server.datanode.fsdataset.impl.FsDatasetImpl (Thread-83): Caught exception while adding replicas from /hadoop/hdfs/data/current. Will throw later.

java.io.IOException: Failed to start sub tasks to add replica in replica map :java.lang.ArithmeticException

at org.apache.hadoop.hdfs.server.datanode.fsdataset.impl.BlockPoolSlice.getVolumeMap(BlockPoolSlice.java:434)

at org.apache.hadoop.hdfs.server.datanode.fsdataset.impl.FsVolumeImpl.getVolumeMap(FsVolumeImpl.java:936)

at org.apache.hadoop.hdfs.server.datanode.fsdataset.impl.FsVolumeList$1.run(FsVolumeList.java:196)

원인

에러의 원인은 버그입니다.

https://issues.apache.org/jira/browse/HDFS-15801

[HDFS-15801] Backport HDFS-14582 to branch-2.10 (Failed to start DN with ArithmeticException when NULL checksum used) - ASF JIRA

In HDFS-14582, the error message is more clear as follows: Caused by: java.lang.ArithmeticException: / by zero at org.apache.hadoop.hdfs.server.datanode.fsdataset.impl.BlockPoolSlice.validateIntegrityAndSetLength(BlockPoolSlice.java:823) at But in branch-2

issues.apache.org

해결 방법

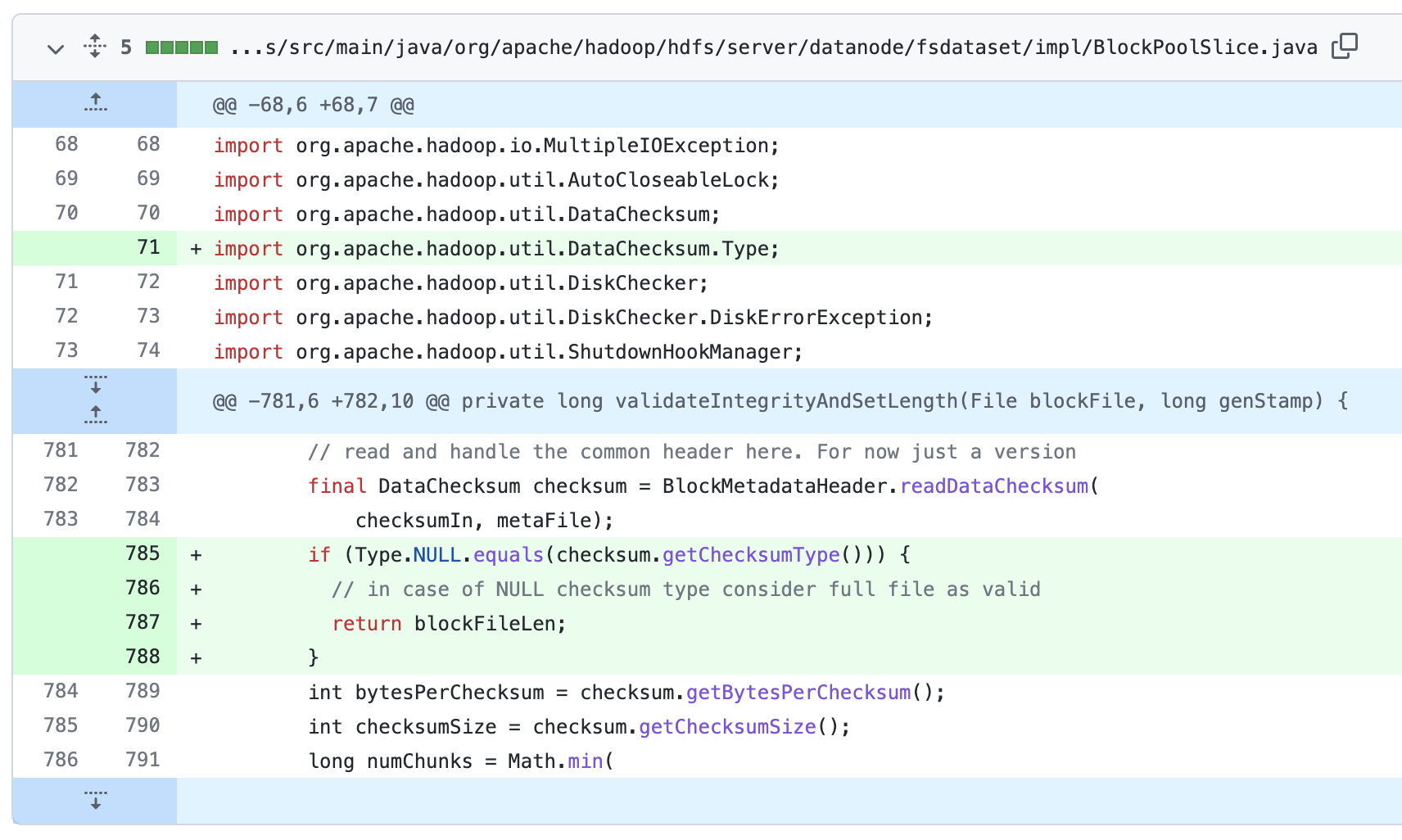

버그로 인한 오류여서 하둡 라이브러리를 새로 빌드하거나, 하둡 버전을 올려야 합니다. BlockPoolSlice.java 파일의 BlockPoolSlice 클래스를 다음과 같이 Null 체크를 추가해 주면 문제를 해결할 수 있습니다.

반응형