[AWS-EMR] EMR 생성중 The requested instance type c4.2xlarge is not supported in the requested availability zone. 오류

[AWS-EMR] EMR 생성중 The requested instance type c4.2xlarge is not supported in the requested availability zone. 오류

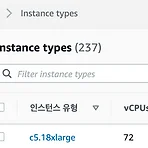

AWS EMR을 생성하는 중 요청한 인스턴스 타입이 지원하지 않는 다는 오류가 발생하느 경우가 있습니다. 이럴때는 EC2 > Instance Types 에서 사용하고자 하는 인스턴스 타입을 선택하고 Networking 항목에서 생성할 수 있는 네트워크 대역을 확인하여 해당 대역을 선택하면 생성할 수 있습니다. 여기서 생성 가능한 영역을 확인하고 EMR을 생성할 때 고급 옵션에서 단계2 하드웨어 > Networking > EC2 서브넷 에서 사용할 수 있는 네트워크 영역을 선택하면 됩니다.

# 예제임 17/10/09 15:19:53 INFO mapreduce.Job: map 67% reduce 0% 17/10/09 15:30:05 INFO mapreduce.Job: Task Id : attempt_1507562353923_0001_m_000000_0, Status : FAILED AttemptID:attempt_1507562353923_0001_m_000000_0 Timed out after 600 secs Sent signal OUTPUT_THREAD_DUMP (SIGQUIT) to pid 6230 as user ubuntu for container container_1507562353923_0001_01_000002, result=success Container killed by the..

우분투에 그라파나를 설치 하는 방법은 다음과 같습니다. 설치 및 실행후 3000번 포트로 접속하면 됩니다. 기본 포트는 3000번 입니다. 최신 버전 다운로드는 다음 위치에서 최신 버전을 확인하면 됩니다. https://grafana.com/grafana/download/9.2.10 Download Grafana | Grafana Labs Overview of how to download and install different versions of Grafana on different operating systems. grafana.com

마리아 DB 를 설치하고, 접속할 때 이런 오류가 발생하는 경우가 있습니다. 이는 타임존이 설정되지 않아서 발생하능 오류입니다. mariadb the server time zone value 'kst' is unrecognized or represents more than one time zone 이때는 마리아 DB 설정에 타임존을 추가합니다. /etc/my.cnf 설정에 다음의 값을 추가합니다. [mysqld] default-time-zone='+9:00'

hdfs에서 파일의 소유자를 설정하는 명령은 chown 입니다. 이 명령을 이용해서 파일의 소유자와 그룹을 설정할 수 있습니다. 만약 특정 유저, 그룹에게 파일이나 디렉토리의 소유 권한을 주고 싶다면 setfacl 명령을 이용할 수 있습니다. setfacl은 같은 그룹이 아닌 사용자에게 파일의 권한을 줄 때 사용할 수 있습니다. hadoop.apache.org/docs/r2.7.1/hadoop-project-dist/hadoop-hdfs/HdfsPermissionsGuide.html

하둡에서 파일 시스템을 변경하거나, 어떤 설정값을 변경하고자 할 때 다음과 같은 경고가 뜨는 경우가 있다. // 경고 2021-03-30 18:49:32,981 WARN [main] org.apache.hadoop.conf.Configuration: job.xml:an attempt to override final parameter: fs.defaultFS; Ignoring. // 오류 java.lang.IllegalArgumentException: Wrong FS: swift://test/tmp/hdfs/.staging, expected: hdfs://localhost 이 경우 core-site.xml 파일을 보면 fs.defaultFS 설정에 true이 들어가 있을 것이다. 이 값이 false 이면 ..

하둡에서 오픈 스택의 swift 파일시스템을 연동하기 위해서는 다음의 라이브러리를 사용하면 됩니다. 이 라이브러리는 sahara의 swift 라이브러리를 수정한 버전 shara 버전은 ORC 파일을 읽을 때 오류가 발생함 walmartlab에서 개발한 이 라이브러리를 이용하면 됨 오픈 스택의 구현 버전에 따라 이 라이브러리가 동작하지 않을 수도 있음 github.com/walmartlabs/hadoop-openstack-swifta walmartlabs/hadoop-openstack-swifta hadoop-openstack-swifta. Contribute to walmartlabs/hadoop-openstack-swifta development by creating an account on GitHu..

21/03/28 11:11:14 INFO mapreduce.Job: Task Id : attempt_1616895550362_0002_m_000000_0, Status : FAILED Error: java.lang.RuntimeException: native snappy library not available: SnappyCompressor has not been loaded. at org.apache.hadoop.io.compress.SnappyCodec.checkNativeCodeLoaded(SnappyCodec.java:72) at org.apache.hadoop.io.compress.SnappyCodec.getCompressorType(SnappyCodec.java:136) at org.apach..

스파크에서 snappy 압축 방식으로 파일을 쓸 때 라이브러를 가져오지 못할 때 다음과 같은 오류가 발생합니다 Caused by: java.lang.UnsatisfiedLinkError: org.apache.hadoop.util.NativeCodeLoader.buildSupportsSnappy()Z at org.apache.hadoop.util.NativeCodeLoader.buildSupportsSnappy(Native Method) at org.apache.hadoop.io.compress.SnappyCodec.checkNativeCodeLoaded(SnappyCodec.java:63) at org.apache.hadoop.io.compress.SnappyCodec.getCompressorType(S..

[기타] JD-GUI에서 No suitable Java version found on your system! 오류가 발생할 때

[기타] JD-GUI에서 No suitable Java version found on your system! 오류가 발생할 때

자바 디컴파일러 JD-GUI에서 다음오류가 발생해서 해결 방법을 검색하다가 Git에서 찾아서 공유합니다. No suitable Java version found on your system! This program requires Java 1.8+ Make sure you install the required Java version. github.com/java-decompiler/jd-gui/issues/332 BigSur ERROR launching 'JD-GUI' · Issue #332 · java-decompiler/jd-gui ERROR launching 'JD-GUI' No suitable Java version found on your system! This program requires Ja..

하둡 distcp 에서 이런 오류가 발생하면 다음의 설정을 추가합니다. 커버러스 적용된 하둡 클러스터간에 위임 토큰을 처리하지 못해서 발생하는 오류입니다. -Dmapreduce.job.hdfs-servers.token-renewal.exclude=server 21/03/04 18:17:19 ERROR tools.DistCp: Exception encountered java.io.IOException: org.apache.hadoop.yarn.exceptions.YarnException: Failed to submit application_1609849426446_23330 to YARN : Failed to renew token: Kind: SWEBHDFS delegation, Service: 10.0...

하둡 yarn의 커패시티 스케줄러의 큐 매핑은 사용자, 그룹에 따라서 자동으로 큐 설정을 변경해 줍니다. 유저A, 그룹 GrpA 유저B, 그룹 GrpB 유저C, 그룹 GrpA, GrpB 위와 같은 경우 유저 A는 큐 GrpA로 작업이 처리되고, 유저 B는 큐 GrpB로 처리됩니다. 유저C는 프라이머리 그룹에 따라 처리 됩니다. 프라이머리 그룹은 사용자의 기본 그룹입니다. /etc/passwd에서 확인할 수 있는 사용자의 기본 그룹입니다. hadoop.apache.org/docs/current/hadoop-yarn/hadoop-yarn-site/CapacityScheduler.html#Dynamic_Auto-Creation_and_Management_of_Leaf_Queues

하둡 DistCp를 이용하여 데이터를 복사할 때 오류가 발생하는 경우가 있습니다. - Socket is closed - Error writing request body to server Caused by: java.net.SocketException: Socket is closed at sun.security.ssl.SSLSocketImpl.getInputStream(SSLSocketImpl.java:680) at sun.net.www.http.HttpClient.parseHTTP(HttpClient.java:673) java.io.IOException: Error writing request body to server at sun.net.www.protocol.http.HttpURLConnection$..

커버러스 티켓 사용중 발생하는 다음의 오류는 클라이언트 서버와 타켓 서버의 시간 동기화가 이루어 지지 않을 때 발생합니다. date 명령으로 서버의 시간을 확인해 보면 시간이 다른 것을 알 수 있습니다. 시간 동기화를 해주면 문제를 해결할 수 있습니다. Caused by: KrbException: Clock skew too great (37) - PROCESS_TGS at sun.security.krb5.KrbTgsRep.(KrbTgsRep.java:73)

하이브를 이용해서 데이터를 처리할 때 파일의 개수와 사이즈가 중요합니다. 동일한 쿼리에서도 설정에 따라 속도차이가 많이 날 수 있습니다. SELECT A, count(*) FROM tbl GROUP BY A ORDER BY A; 칼럼 A로 파티셔닝 파티션당 60 여개의 ORC 파일 파일당 10~20KB 이 상황에서 TEZ엔진 기본설정으로 쿼리를 실행하면 2148초가 걸립니다. 파일의 사이즈가 작아서 매퍼가 작게 생성되지만, ORC 파일의 특성상 하나의 파일에 많은 데이터가 들어가게 되고, 이 데이터를 모두 처리하는데 많은 메모리가 소모되기 때문입니다. 이런 경우 TEZ엔진의 그룹핑 사이즈를 조절하여 매퍼의 개수를 늘려서, 하나의 매퍼가 처리하는 데이터를 줄이면 속도가 빨라지는 것을 확인할 수 있습니다. ..

자바 응용프로그램을 실행하는 중에 Xmx를 4G로 설정했는데 실제 메모리는 7G를 먹고 있어서 원인을 확인해 보았습니다. Xmx는 힙의 최대 메모리를 설정하는 명령입니다. JVM은 힙외에 다양한 요소들로 구성되어 있고 이 부분이 메모리를 사용합니다. # Xmx: 힙의 최대 메모리 사이즈 # MaxPermSize: Permanent Size 최대 메모리 # Xss: 스레드에 할당되는 Stack 사이즈 Max memory = [-Xmx] + [-XX:MaxPermSize] + number_of_threads * [-Xss] 힙영영외 나머지 영역에서 메모리가 필요하여 사용메모리가 늘어납니다. GC: 가비지 수집을 위한 메모리. 사용 중인 개체의 추적을 위한 그래프 생성. G1GC는 더 많은 메모리를 사용합니다..

jsvc를 이용할 때 다음의 오류가 발생하는 경우가 있습니다. Invalid JVM name specified server Cannot locate JVM library file Service exit with a return value of 1 원인 이 오류는 jsvc를 실행할 때 전달하는 jvm의 이름이 틀렸기 때문입니다. JVM의 종류가 다양하기 때문에 자신이 사용하는 JVM의 정보를 확인하고 이 이름을 전달하면 됩니다. OpenJDK나 HotSpot은 jvm이름이 server 이기 때[문에 일반적인 설정에서는 문제가 없으나, 이클립스 VM의 경우 이름이 j9vm 이라서 이런 오류가 발생할 수 있습니다. JVM 이름 확인 JVM이름을 확인하고 이 이름을 JSVC 명령어에서 이요할 수 있습니다. JS..

하둡에서 HDFS를 HA로 구성하면 WebHDFS를 사용할 때 스탠바이 노드에 요청을 해도, 액티브 노드로 연결을 넘겨주어 자연스럽게 작업을 처리할 수 있습니다. HTTP로 구성한 HA에서는 가능한데, HTTPS로 구성한 HA 환경에서는 작업이 처리되지 않았습니다. HTTPS로 스탠바이 노드에 요청을 하면 다음과 같은 오류를 확인할 수 있습니다. 2021-01-28 10:05:34,120 WARN org.mortbay.log (): SSL renegotiate denied: java.nio.channels.SocketChannel[connected local=/] SSL renegotiate 오류 TLS 1.3 환경에서는 중간자 공격등이 가능하여 SSL 재협상 기능을 제거했다고 합니다. 따라서 네트워크 ..

HBase 작업 중 Master is initializing 오류가 발생하는 경우가 있습니다. 마스터가 초기화 중일 때 리전 서버가 연결되지 않았을 때 리전서버가 마스터에 연결되지 않았을 때 /etc/hosts 정보가 설정되지 않았을 HBase는 마스터와 리전서버간에 모든 서버의 정보를 각 노드가 알고 있어야 함. 리버스 DNS가 처리되지 않는 환경이라면 /etc/hosts에 정보가 있어야 함 블록 정보를 아직 처리중 일 때 데이터가 깨졌을 때 HDFS의 데이터를 삭제하고 재부팅 주키퍼의 hbase 정보를 삭제하고 재부팅

hbase는 기본적으로 ACL을 설정하지 않습니다. ACL을 설정하지 않으면 관련 명령어를 실행할 때 ERROR: DISABLED: Security features are not available 오류가 발생합니다. hbase 에서 ACL을 적용하기 위해서는 hbase-site.xml에 다음 설정을 추가합니다. 그리고 hbase를 재부팅 하면 됩니다. hbase에 ACL을 적용하면 접근할 수 있는 테이블만 보이고, 권한이 있는 네임스페이스에 테이블을 생성할 수 있습니다. HBase ACL 명령어 ACL관련 명령어는 다음과 같습니다.

2021-01-19 11:41:00,345 - ERROR [main:QuorumPeerMain@89] - Unexpected exception, exiting abnormally java.io.IOException: Could not configure server because SASL configuration did not allow the ZooKeeper server to authenticate itself properly: javax.security.auth.login.LoginException: Message stream modified (41) at org.apache.zookeeper.server.ServerCnxnFactory.configureSaslLogin(ServerCnxnFactor..

- Total

- Today

- Yesterday

- Linux

- HDFS

- S3

- build

- 알고리즘

- AWS

- ubuntu

- error

- Hadoop

- java

- Tez

- bash

- 다이나믹

- oozie

- SPARK

- yarn

- HIVE

- 오류

- emr

- 백준

- SQL

- nodejs

- airflow

- Python

- 하둡

- 하이브

- hbase

- mysql

- 파이썬

- 정올

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |